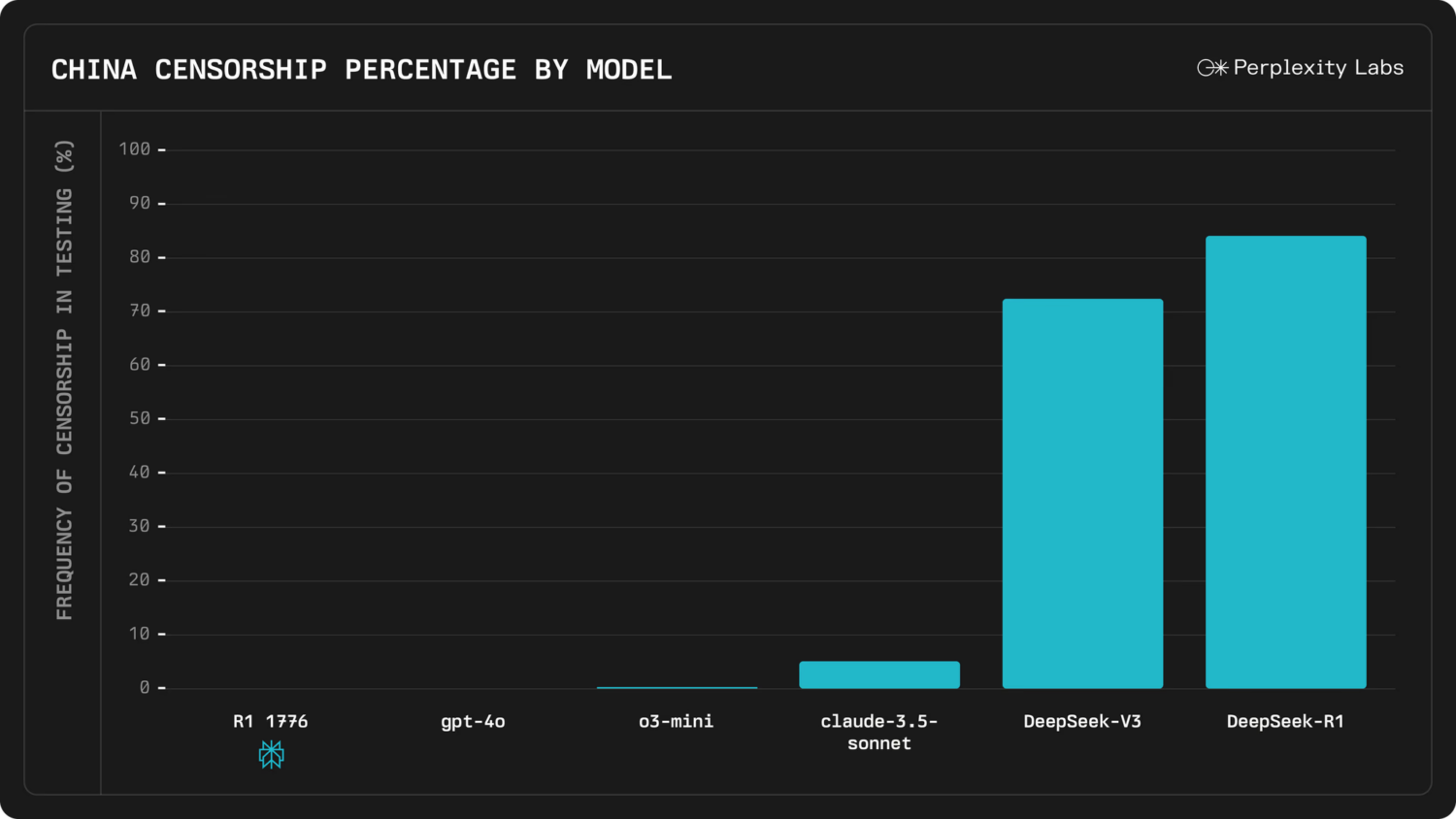

Perplexity 宣布開源 R1 1776,這是一個基於 DeepSeek-R1 的大型語言模型 (LLM),但經過特別後訓練,以確保其提供準確、中立且無偏見的回答。這個版本不再受中國政府的審查影響,能夠自由討論包括地緣政治、經濟影響等敏感話題。如果你曾因 AI 拒絕回答某些問題而感到受限,那麼 R1 1776 可能是你一直在等待的解決方案!

為何要改造 DeepSeek-R1?

DeepSeek-R1 是一個性能接近最先進推理模型 (如 o1 和 o3-mini) 的 LLM,然而,它在處理敏感話題時受到嚴格限制。例如,當被問及 「台灣獨立對 Nvidia 股價的影響」時,原版 R1 會以中共官方立場回應,甚至完全忽略問題本身 (過程可以參考官方的公告)。

這樣的審查嚴重限制了 R1 的應用範圍,無法提供客觀、完整的資訊。Perplexity 為了要打造一個能夠誠實回答所有問題的 AI,因此決定進行後訓練,讓 R1 擺脫這些限制,成為真正開放、無偏見的 AI。

R1 1776 如何去除審查?

為了讓 R1 具備回答敏感問題的能力,Perplexity 採用了精密的後訓練 (post training) 技術,主要包含以下步驟:

1. 構建審查資料集

Perplexity 首先聘請專家辨識了 300 個已知被中國政府審查的話題,並開發了一個多語言審查分類器來篩選相關查詢。這些數據經過嚴格過濾,確保不包含個人資訊 (PII),最終累積了 40,000 筆多語言數據作為訓練資料。

2. 蒐集高品質回答

為了確保 AI 能夠提供準確、合邏輯的回答,Perplexity 特別強調 「Chain-of-Thought」(思維鏈) 推理能力,並採用了多種方式來確保回答的多樣性和品質,包括使用人工標註、驗證數據可靠性等方法。

3. 以 NeMo 2.0 進行後訓練

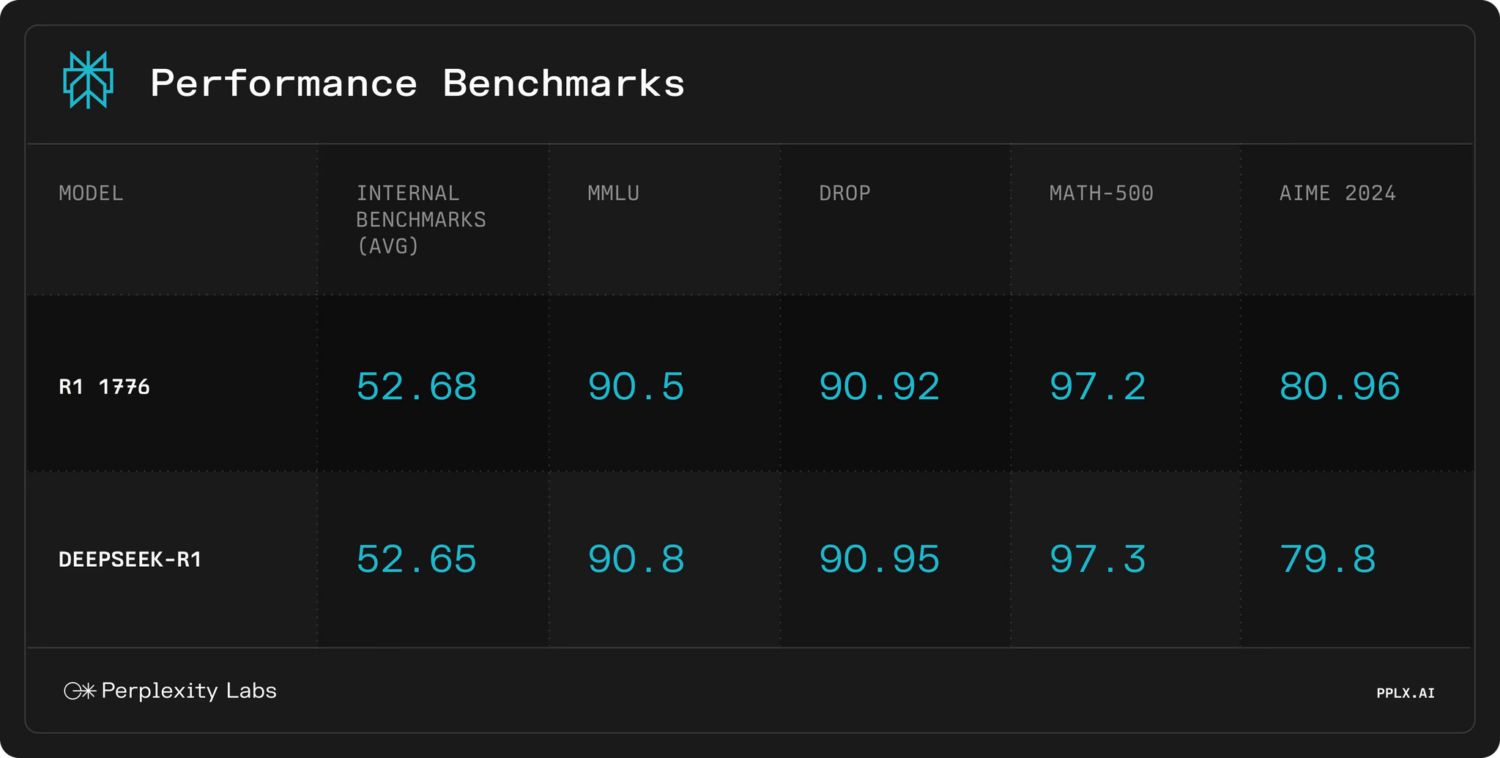

模型訓練使用了 Nvidia 的 NeMo 2.0 框架,並設計了特殊的調校方式,確保在去除審查的同時,不影響模型的數學與推理能力。

評估

為了確保 R1 1776 真正去除了審查,Perplexity 建立了一個 1,000 多條問題的測試集,涵蓋各種敏感話題,並使用人工標註與 LLM 評審來檢測模型是否仍會「閃躲」或給出過於保守的回答。結果顯示,R1 1776 成功克服審查問題,同時保持與原版 R1 相當的數學與推理能力。

👉Perplixity 公告

https://www.perplexity.ai/hub/blog/open-sourcing-r1-1776

👉Perplixity 已經將訓練後的模型權重上傳到 HuggingFace 開源