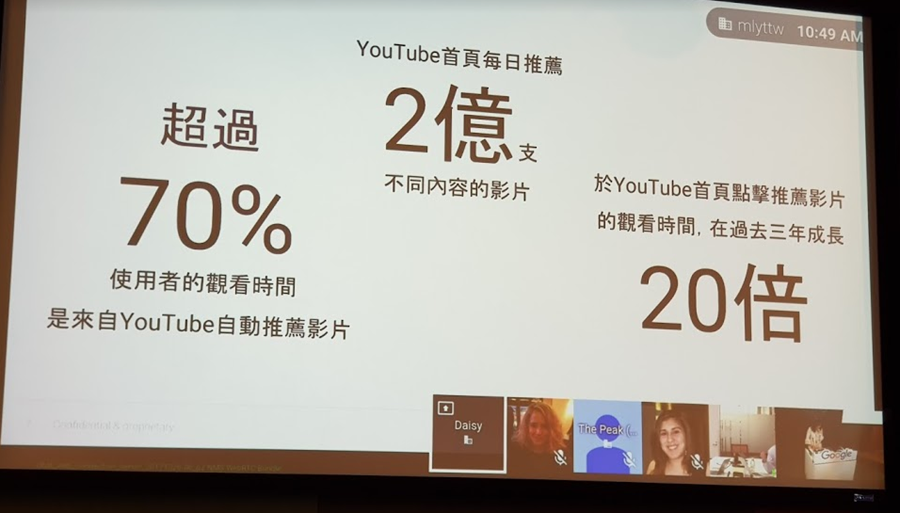

YouTube 是全世界最大的影音平台之一,目前已經有數百萬個影音內容在 YouTube 上產生,目前每分鐘也有超過 500 小時的影片被上傳到 YouTube 上,因此對於 YouTube 來說,如何在短時間內透過人工智慧技術分析被上傳的每一個影音內容,並依照興趣推薦給每個不同的人,提高觀眾的參與度和滿意度是非常重要的課題。

在進行影片推薦之前,YouTube 必須面臨幾個棘手的問題。首先是影音內容的標記(annotation),由於影片內容相當複雜,演算法必須先分析影片內容才可進行更進一步的推薦,因此在發展推薦模型之前,YouTube 必須先建立有效的影片內容標記技術。

此外,面對影音及使用者互動資料不斷的更新,演算也必須能因應使用者的行為擁有快速的反應能力,才能提高使用者的興趣及停留於平台上的時間。

而在訓練的過程中,由於不論是影音內容或使用者行為都會產生相當多的雜訊,且並非所有的資訊都能被量化為推薦演算法可使用的參數,因此 YouTube 的團隊便要嘗試將各種不同的顯性、隱性回饋都能夠被量化,並納入訓練資料中,例如影音下方的「我喜歡」(顯性)、看完一段影片(隱性)等行為。

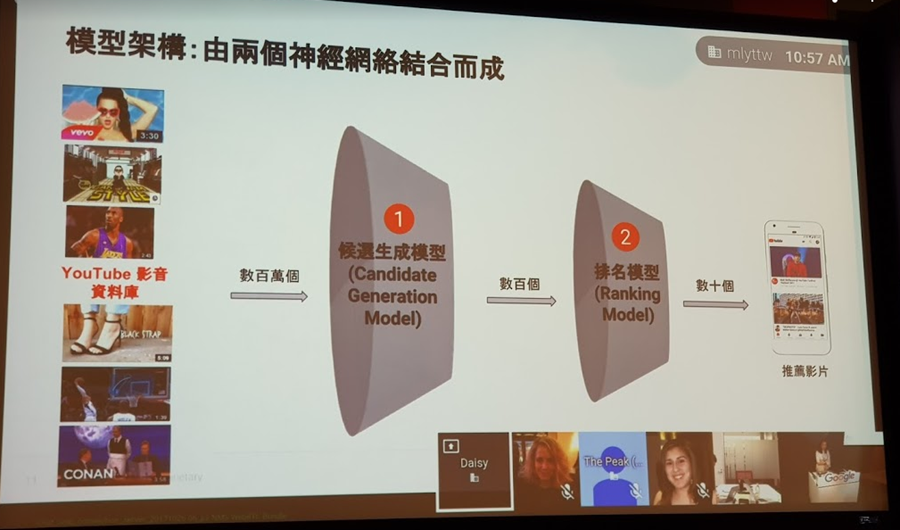

因應不斷且快速變化的資訊輸入,YouTube 過去以迴歸(regression)模型為基礎的推薦演算法也相形見絀,因此 YouTube 在 2015 年開始將機器學習(machine learning)技術導入 YouTube 推薦機制,提供更快速精準的個人化推薦。目前 YouTube 的推薦機制包含了 2 個神經網路模型(nural network):

1. 候選生成模型 (Candidate Generation Model)

由個人的瀏覽歷史、搜尋歷史、人口統計資料等資料,從數百萬的影片資料庫中挑選與使用者相關的子集合,供後續第二層演算法參考使用。

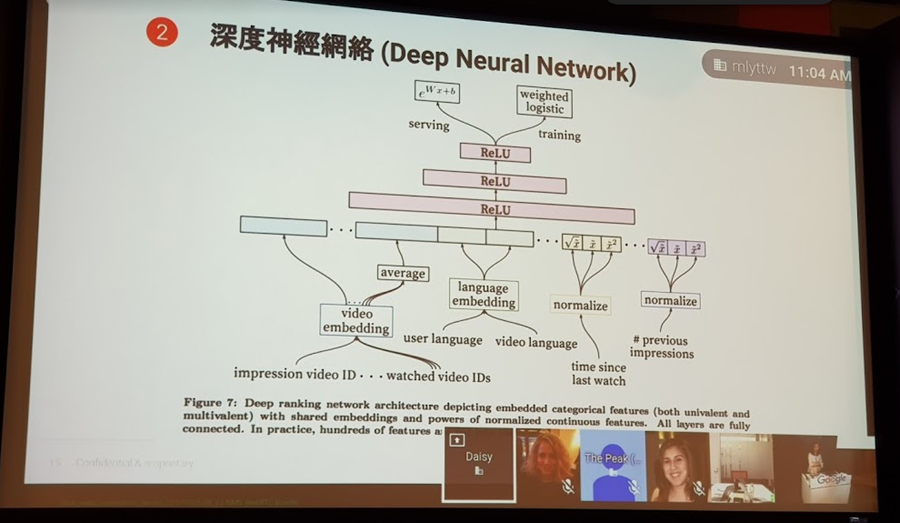

2. 排名模型(Ranking Model)

在有了候選清單後,第二步驟即是從名單中預測使用者最有興趣觀賞的影片,並進行推薦排名。因此 YouTube 參考了以下訊號進行權重的計算:

- 人口統計資料

- 最受歡迎的影音

- 使用者的影片和使用的語言

- 近期觀看紀錄

- 使用者和影音頻道的過往連結

而為了能夠讓 YouTube 的演算法針對影片中的內容做更詳細的識別,YouTube 研發團隊也發表了原子視覺化動作數據學習模式(Automic Visual Actions, AVA)技術,透過電腦圖形識別技術判斷影片中人類姿勢、人與物體、人與人的互動行為。

AVA 的運作將每個影片擷取 15 分鐘的片段,再將影片均分為 300 組 3 秒的影片片段(合計共 900 秒),再藉由已經預先定義好的 80 組原子動作 (automi action)進行比對,找出如走路、踢球、握手之類的動作特徵並進行標註。